使用Python爬取小姐姐圖片(beautifulsoup法)

Python有許多強(qiáng)大的庫(kù)用于爬蟲,如beautifulsoup、requests等,本文將以網(wǎng)站https://www.xiurenji.cc/XiuRen/為例(慎點(diǎn)!!),講解網(wǎng)絡(luò)爬取圖片的一般步驟。為什么選擇這個(gè)網(wǎng)站?其實(shí)與網(wǎng)站的內(nèi)容無(wú)關(guān)。主要有兩項(xiàng)技術(shù)層面的原因:①該網(wǎng)站的頁(yè)面構(gòu)造較有規(guī)律,適合新手對(duì)爬蟲的技巧加強(qiáng)認(rèn)識(shí)。②該網(wǎng)站沒(méi)有反爬蟲機(jī)制,可以放心使用爬蟲。

第三方庫(kù)需求

beautifulsoup requests 步驟打開網(wǎng)站,點(diǎn)擊不同的頁(yè)面:發(fā)現(xiàn)其首頁(yè)是https://www.xiurenji.cc/XiuRen/,而第二頁(yè)是https://www.xiurenji.cc/XiuRen/index2.html,第三頁(yè)第四頁(yè)以此類推。為了爬蟲代碼的普適性,我們不妨從第二頁(yè)以后進(jìn)行構(gòu)造url。

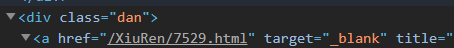

選中封面圖片,點(diǎn)擊檢查:

可以發(fā)現(xiàn),圖片的信息,都在’div’,class_=’dan’里,而鏈接又在a標(biāo)簽下的href里。據(jù)此我們可以寫一段代碼提取出每一個(gè)封面圖片的url:

def getFirstPage(page): url=’https://www.xiurenji.cc/XiuRen/index’+str(page)+’.html’#獲得網(wǎng)站每一個(gè)首頁(yè)的網(wǎng)址 res=requests.get(url)#發(fā)送請(qǐng)求 res.encoding='gbk'#設(shè)置編碼方式為gbk html=res.text soup=BeautifulSoup(html,features=’lxml’) lists=soup.find_all(’div’,class_=’dan’)#找到儲(chǔ)存每一個(gè)封面圖片的標(biāo)簽值 urls=[] for item in lists: url1=item.find(’a’).get(’href’)#尋找每一個(gè)封面對(duì)應(yīng)的網(wǎng)址 urls.append(’https://www.xiurenji.cc’+url1)#在列表的尾部添加一個(gè)元素,達(dá)到擴(kuò)充列表的目的,注意要把網(wǎng)址擴(kuò)充完整 return urls#返回該主頁(yè)每一個(gè)封面對(duì)應(yīng)的網(wǎng)址

點(diǎn)擊封面圖片,打開不同的頁(yè)面,可以發(fā)現(xiàn),首頁(yè)的網(wǎng)址是https://www.xiurenji.cc/XiuRen/xxxx.html,而第二頁(yè)的網(wǎng)址是https://www.xiurenji.cc/XiuRen/xxxx_1.html,第三第四頁(yè)同理。同樣為了普適性,我們從第二頁(yè)開始爬取。

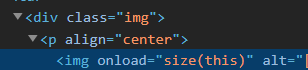

右鍵,點(diǎn)擊“檢查”:

可以發(fā)現(xiàn)所有的圖片信息都儲(chǔ)存在’div’,class_=’img’中,鏈接、標(biāo)題分別在img標(biāo)簽中的src和alt中,我們同樣也可以將它們提取出來(lái)。

def getFirstPage(page): url=’https://www.xiurenji.cc/XiuRen/index’+str(page)+’.html’#獲得網(wǎng)站每一個(gè)首頁(yè)的網(wǎng)址 res=requests.get(url)#發(fā)送請(qǐng)求 res.encoding='gbk'#設(shè)置編碼方式為gbk html=res.text soup=BeautifulSoup(html,features=’lxml’) lists=soup.find_all(’div’,class_=’dan’)#找到儲(chǔ)存每一個(gè)封面圖片的標(biāo)簽值 urls=[] for item in lists: url1=item.find(’a’).get(’href’)#尋找每一個(gè)封面對(duì)應(yīng)的網(wǎng)址 urls.append(’https://www.xiurenji.cc’+url1)#在列表的尾部添加一個(gè)元素,達(dá)到擴(kuò)充列表的目的,注意要把網(wǎng)址擴(kuò)充完整 return urls#返回該主頁(yè)每一個(gè)封面對(duì)應(yīng)的網(wǎng)址

完整代碼

import requestsfrom bs4 import BeautifulSoupdef getFirstPage(page): url=’https://www.xiurenji.cc/XiuRen/index’+str(page)+’.html’#獲得網(wǎng)站每一個(gè)首頁(yè)的網(wǎng)址 res=requests.get(url)#發(fā)送請(qǐng)求 res.encoding='gbk'#設(shè)置編碼方式為gbk html=res.text soup=BeautifulSoup(html,features=’lxml’) lists=soup.find_all(’div’,class_=’dan’)#找到儲(chǔ)存每一個(gè)封面圖片的標(biāo)簽值 urls=[] for item in lists: url1=item.find(’a’).get(’href’)#尋找每一個(gè)封面對(duì)應(yīng)的網(wǎng)址 urls.append(’https://www.xiurenji.cc’+url1)#在列表的尾部添加一個(gè)元素,達(dá)到擴(kuò)充列表的目的,注意要把網(wǎng)址擴(kuò)充完整 return urls#返回該主頁(yè)每一個(gè)封面對(duì)應(yīng)的網(wǎng)址def download(urls): for url1 in urls: print('prepare to download pictures in '+url1) getEveryPage(url1)#下載頁(yè)面內(nèi)的圖片 print('all pictures in '+url1+'are downloaded') def getEveryPage(url1): total=0#total的作用:對(duì)屬于每一個(gè)封面內(nèi)的圖片一次編號(hào) for n in range (1,11):#每一個(gè)封面對(duì)應(yīng)下載10張圖,可自行調(diào)整 temp=url1.replace(’.html’,’’) url2=temp+’_’+str(n)+’.html’#獲得每一內(nèi)部頁(yè)面的網(wǎng)址 res=requests.get(url2) res.encoding='gbk' html=res.text soup=BeautifulSoup(html,features=’lxml’) lists1=soup.find_all(’div’,class_=’img’)#儲(chǔ)存圖片的路徑 for item in lists1: url=item.find(’img’).get(’src’) title=item.find(’img’).get(’alt’)#獲取圖片及其標(biāo)題 picurl=’https://www.xiurenji.cc’+url#獲取完整的圖片標(biāo)題 picture=requests.get(picurl).content#下載圖片 address=’D:pythonimages’+’’#自定義保存圖片的路徑 with open(address+title+str(total)+’.jpg’,’wb’) as file:#保存圖片 print('downloading'+title+str(total)) total=total+1 file.write(picture) if __name__ == '__main__': page=int(input(’input the page you want:’)) urls=getFirstPage(page) download(urls)

本文僅供學(xué)習(xí)參考,切勿用作其他用途!

到此這篇關(guān)于Python爬取小姐姐圖片(beautifulsoup法)的文章就介紹到這了,更多相關(guān)Python爬取小姐姐圖片內(nèi)容請(qǐng)搜索好吧啦網(wǎng)以前的文章或繼續(xù)瀏覽下面的相關(guān)文章希望大家以后多多支持好吧啦網(wǎng)!

相關(guān)文章:

1. Spring security 自定義過(guò)濾器實(shí)現(xiàn)Json參數(shù)傳遞并兼容表單參數(shù)(實(shí)例代碼)2. JAMon(Java Application Monitor)備忘記3. Java類加載機(jī)制實(shí)現(xiàn)步驟解析4. Python os庫(kù)常用操作代碼匯總5. Python 如何展開嵌套的序列6. 在JSP中使用formatNumber控制要顯示的小數(shù)位數(shù)方法7. Python OpenCV去除字母后面的雜線操作8. Python TestSuite生成測(cè)試報(bào)告過(guò)程解析9. 增大python字體的方法步驟10. 如何清空python的變量

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備